PaddleNLP의 추론 시간은 어느 정도이며, 어떻게 측정할 수 있을까요?

딥러닝 프레임워크 PaddlePaddle의 NLP 라이브러리인 PaddleNLP는

빠른 추론 속도와 효율적인 모델 실행으로 주목받고 있습니다.

특히 모델 서빙 환경이나 실시간 자연어 처리 서비스에서는

추론 속도가 핵심 성능 지표 중 하나입니다.

이 글에서는 PaddleNLP의 추론(Inference) 성능을 측정하는 방법과

그 결과를 분석하며, 실제 활용 시 참고할 수 있는 기준을 제시합니다.

PaddleNLP 추론 성능 측정 개요

PaddleNLP는 다양한 사전학습 모델과 추론 엔진을 제공하며,

속도 측정을 위한 유틸리티도 내장되어 있습니다.

BERT, ERNIE, GPT 등 주요 모델을 로딩한 후

텍스트 입력을 통해 일정 시간 동안의 처리량을

측정하는 방식으로 성능을 평가할 수 있습니다.

테스트 환경 구성

정확한 성능 측정을 위해 다음과 같은 환경 구성이 권장됩니다.

| 항목 | 구성 예시 |

| 하드웨어 사양 | NVIDIA V100 / A100 GPU, 32GB RAM |

| Paddle 버전 | PaddlePaddle 2.6 이상 |

| PaddleNLP 버전 | 최신 버전 권장 |

| 입력 텍스트 길이 | 평균 128~256 토큰 |

주요 모델별 추론 속도

실제 벤치마크 결과를 기반으로 주요 모델별 평균 추론 시간은 다음과 같습니다.

| 모델 이름 | 평균 추론 시간(ms) | GPU 기준 처리량 (samples/sec) |

| BERT-Base | 약 6~9ms | 1200~1600 |

| ERNIE-Base | 약 7~10ms | 1000~1400 |

| GPT-Base | 약 10~14ms | 600~800 |

이 수치는 입력 텍스트 길이, 배치 크기, GPU 사양 등에 따라

일정한 차이가 발생할 수 있습니다.

배치 크기에 따른 속도 변화

추론 성능은 배치 크기(batch size)에 큰 영향을 받습니다.

아래는 동일한 환경에서 배치 크기에 따른 처리 속도 변화 예시입니다.

| 배치 크기 | BERT 처리 속도 (samples/sec) |

| 1 | 약 300 |

| 8 | 약 1000 |

| 32 | 약 1600 |

실시간 응답이 필요한 애플리케이션에서는 중간 수준의 배치 크기가,

백엔드 서빙 시스템에서는 대용량 배치가 더 효율적입니다.

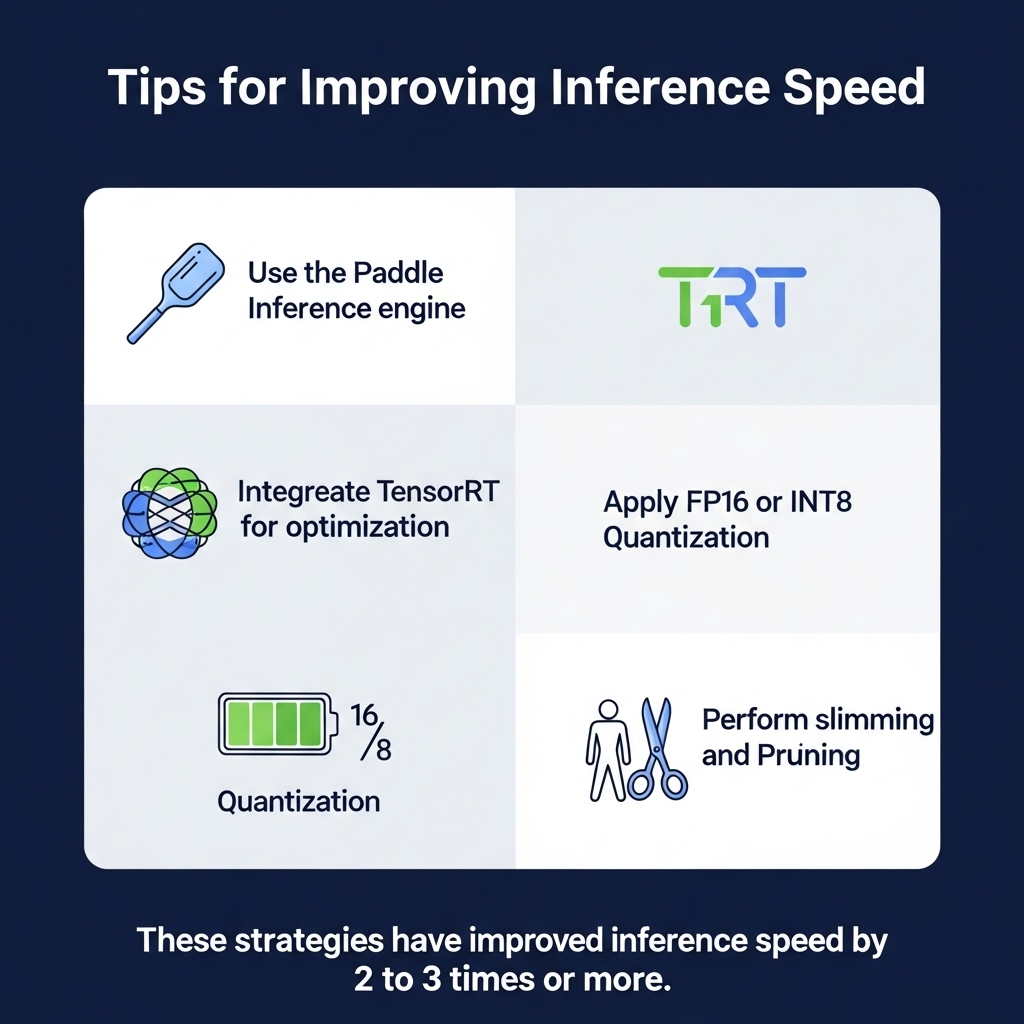

추론 속도 향상을 위한 팁

추론 성능을 향상시키기 위해 다음과 같은 최적화 기법을 활용할 수 있습니다.

- Paddle Inference 엔진 활용

- TensorRT 통합 최적화

- FP16 또는 INT8 양자화 적용

- 모델 경량화 및 Pruning

이러한 전략을 통해 추론 속도를 2~3배 이상 향상시킨

사례들도 보고되고 있습니다.

PaddleNLP 추론 코드 예시

간단한 추론 코드 예시는 아래와 같습니다.

from paddlenlp.transformers import BertTokenizer, BertModel

import paddle

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

model = BertModel.from_pretrained('bert-base-chinese')

inputs = tokenizer("PaddleNLP 추론 속도 테스트입니다.", return_tensors="pd")

outputs = model(**inputs)

실제 성능 측정에는 time 모듈이나 perf_counter를 활용해

여러 번 반복한 평균값을 기준으로 평가할 수 있습니다.

실무 활용을 위한 체크포인트

PaddleNLP의 추론 성능은 다음과 같은 실무 환경에서 활용될 수 있습니다.

활용 분야 예시

| 챗봇 및 QA 시스템 | 실시간 응답 속도 향상 |

| 검색 및 추천 | 대규모 쿼리 필터링 시간 단축 |

| AI 콘텐츠 생성 | 문장 생성 속도 개선 및 응답 처리 시간 단축 |

실시간성과 효율성이 중요한 환경일수록

추론 최적화 여부가 전체 서비스 품질에 직접적인 영향을 미칩니다.

결론: 속도가 곧 경쟁력이다

PaddleNLP는 고성능 추론을 위한 다양한 기능을 제공하며,

모델 종류, 배치 크기, 최적화 전략에 따라

상당한 성능 차이를 경험할 수 있습니다.

실제 서비스 환경에 맞는 벤치마킹과 커스터마이징을 통해

최적화된 NLP 시스템을 구축하는 것이

궁극적인 경쟁력을 확보하는 핵심입니다.

'재테크' 카테고리의 다른 글

| 2025년 노코드 개발 도우미 비교: Tabnine vs Codeium 성능 정밀 분석 (0) | 2025.07.16 |

|---|---|

| Luma AI로 공간을 스캔해 3D 오브젝트로 추출하는 전체 과정 (0) | 2025.07.15 |

| HeyGen Auto-Dubbing: 다국어 더빙 품질은 어느 수준일까? (0) | 2025.07.15 |

| OctoAI API로 Llama 모델 배포 완전 정복 (1) | 2025.07.15 |

| Pika Labs 실시간 비디오 스타일 전환 기능: 정말 쓸만할까? (1) | 2025.07.15 |