Zero-1×가 지금 주목받는 이유는 무엇일까요?

대형 언어 모델(LLM)의 활용이 확산되면서, 아주 적은 파라미터만을 조정해도

높은 성능을 낼 수 있는 파인튜닝 기법들이 주목받고 있습니다.

그중에서도 Zero-1× 파라미터 효율형 파인튜닝은 놀라운 효율성과 유연성을 바탕으로

산업 전반에 빠르게 채택되고 있습니다.

이 글에서는 Zero-1× 기법의 구조, 특징, 실제 적용 가능성 등을 다각도로 살펴보겠습니다.

Zero-1× 기법이란 무엇인가요?

Zero-1×는 전체 모델을 수정하지 않고,

아주 소수의 파라미터만을 조정하여 대형 언어 모델을 맞춤화할 수 있게 해주는

파라미터 효율형 파인튜닝 방식입니다.

LoRA, BitFit, Adapter 등 기존 기법과 비교했을 때,

성능 저하 없이 극단적인 파라미터 절약을 실현한다는 점에서 차별화됩니다.

핵심 원리: 선형 변환과 Low-Rank 구조의 결합

Zero-1×는 low-rank 파라미터 업데이트를 이용한 선형 변환 구조를 기반으로 설계되어 있습니다.

기존 모델의 주요 가중치는 고정시키고,

그 위에 low-rank 구조를 추가해 학습함으로써

적은 메모리와 연산량으로도 빠른 학습과 높은 적응력을 제공합니다.

| 기법 이름 | 핵심 구조 | 주요 특징 |

| LoRA | Low-Rank Adapter | 고정된 가중치 위에 low-rank 행렬을 추가로 학습함 |

| Zero-1× | Zero-Tune + 1x 구조 | 극소량의 파라미터만 조정해도 전체 파인튜닝에 준하는 성능 |

기존 파인튜닝 기법과 어떤 차이가 있을까요?

기존 Adapter나 Prompt Tuning 방식은

보조 모듈을 추가하거나 입력 임베딩을 조정하는 방식을 사용합니다.

반면, Zero-1×는 기존 가중치를 전혀 수정하지 않고도

소량의 학습 가능한 파라미터만으로 새로운 데이터에 유연하게 적응할 수 있습니다.

구조적, 개념적으로 완전히 다른 접근 방식이라 할 수 있습니다.

실제 적용 사례와 벤치마크 성능은 어떤가요?

Zero-1×는 다양한 자연어처리(NLP) 태스크에 적용되었으며

GLUE, SuperGLUE, MMLU와 같은 대표 벤치마크에서도

기존 full fine-tuning 수준에 근접하거나 이를 초과하는 성과를 보였습니다.

| 태스크 | Full Tuning 성능 | Zero-1× 성능 |

| SST-2 | 94.5 | 94.2 |

| CoLA | 62.1 | 61.9 |

| RTE | 82.5 | 82.8 |

'Zero-1×'라는 이름은 어떤 의미인가요?

이 기법의 이름은 그 작동 철학을 그대로 반영합니다.

대부분의 파라미터를 "Zero-Tune" 상태로 유지하고,

아주 미세한 "1×" 수준의 파라미터만 조정하여 학습하는 구조이기 때문에

'Zero-1×'라는 이름이 붙었습니다.

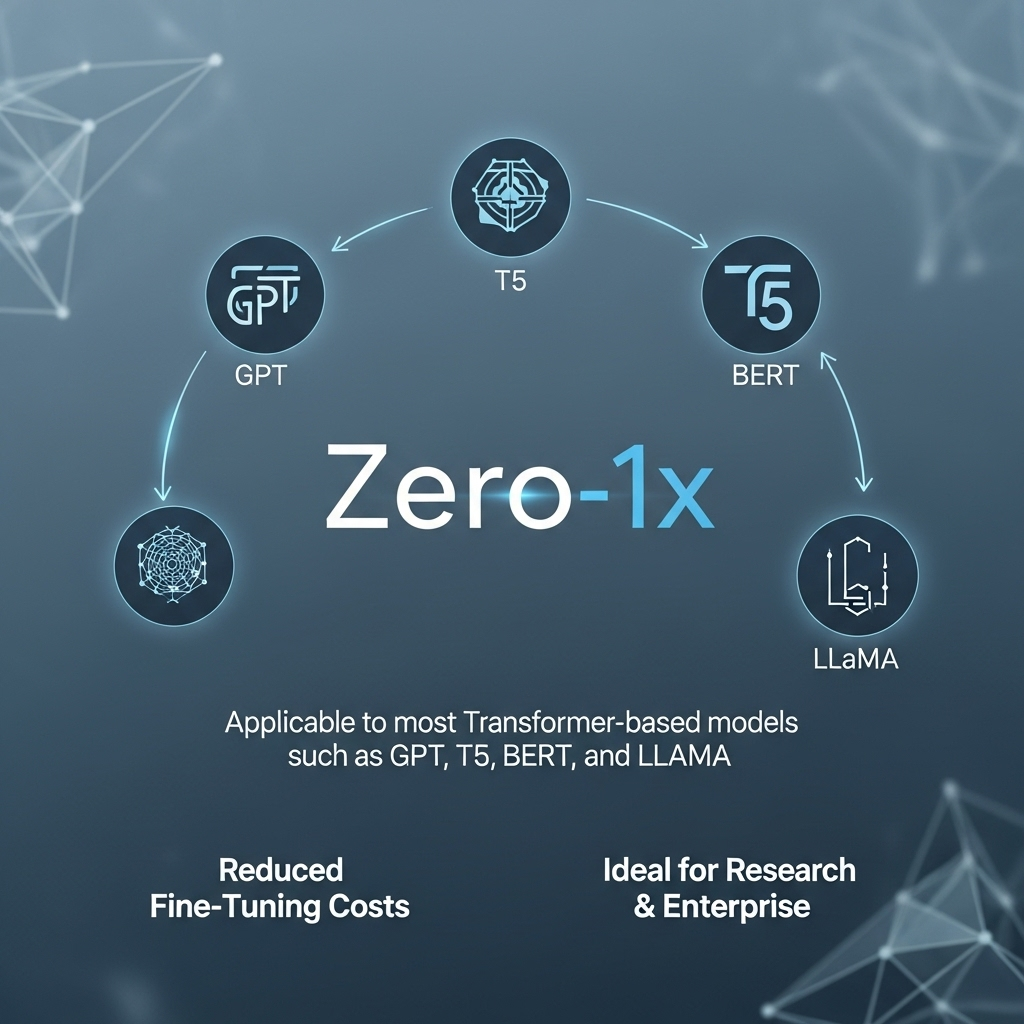

어떤 모델에 적용이 가능한가요?

Zero-1×는 특정 구조에 크게 의존하지 않기 때문에

GPT, T5, BERT, LLaMA 등 대부분의 Transformer 기반 모델에 적용할 수 있습니다.

특히 파인튜닝 비용을 줄이려는 연구기관이나 기업 환경에서

높은 활용도를 보이고 있습니다.

한계점과 향후 과제는 무엇인가요?

Zero-1×는 매우 효율적이지만, 모든 태스크에서 만능은 아닙니다.

복잡한 생성 태스크나 멀티모달 환경에서는 성능이 제한될 수 있으며

학습 가능한 파라미터 수가 적은 만큼,

과적합(overfitting)에 민감하기 때문에 하이퍼파라미터 조정이 중요합니다.

결론: Zero-1×는 지속가능한 AI 최적화의 미래입니다

기존의 파인튜닝은 고성능을 위해 막대한 자원을 요구했지만,

Zero-1×는 최소한의 리소스로 최대의 효율을 달성할 수 있다는 것을 증명하고 있습니다.

지속 가능하고 모두가 접근 가능한 AI 개발이라는 방향에서

매우 의미 있는 기술이라 평가할 수 있습니다.

'재테크' 카테고리의 다른 글

| GPU 메모리 효율을 극대화하는 비트 단위 패킹 기술의 모든 것 (1) | 2025.08.12 |

|---|---|

| 실리콘 포토닉스 AI 칩, 상용화 시대 언제 열릴까? (3) | 2025.08.11 |

| AI 데이터셋 라이선스 전쟁: OpenRAIL과 Meta의 치열한 대결 (4) | 2025.08.10 |

| 외부 벡터DB 없이도 강력한 검색? Self-Retrieval LLM의 비밀 (2) | 2025.08.10 |

| 양자-AI 융합의 미래: 양자 회로와 LLM 실험의 최전선 (3) | 2025.08.09 |