인간처럼 인식하고 표현하는 AI, 어디까지 왔을까?

멀티모달 LLM은 텍스트뿐만 아니라 음성, 이미지, 비디오까지

처리할 수 있는 인공지능의 핵심 기술로 떠오르고 있습니다.

이 글에서는 멀티모달 LLM의 핵심 개념과 최신 기술 동향,

활용 사례, 앞으로의 진화 방향을 종합적으로 살펴봅니다.

텍스트 기반 LLM에서 멀티모달로의 전환

기존의 LLM은 텍스트만을 활용해 언어 이해와 생성에 뛰어났습니다.

하지만 인간의 인식은 언어에만 국한되지 않기 때문에,

이미지나 음성과 같은 비언어적 데이터를 포괄하는

멀티모달 방식이 등장하게 되었습니다.

그 결과, AI는 점점 더 사람처럼 맥락을 인식하고

표현할 수 있게 되었으며, 표현력과 이해도가 크게 향상되었습니다.

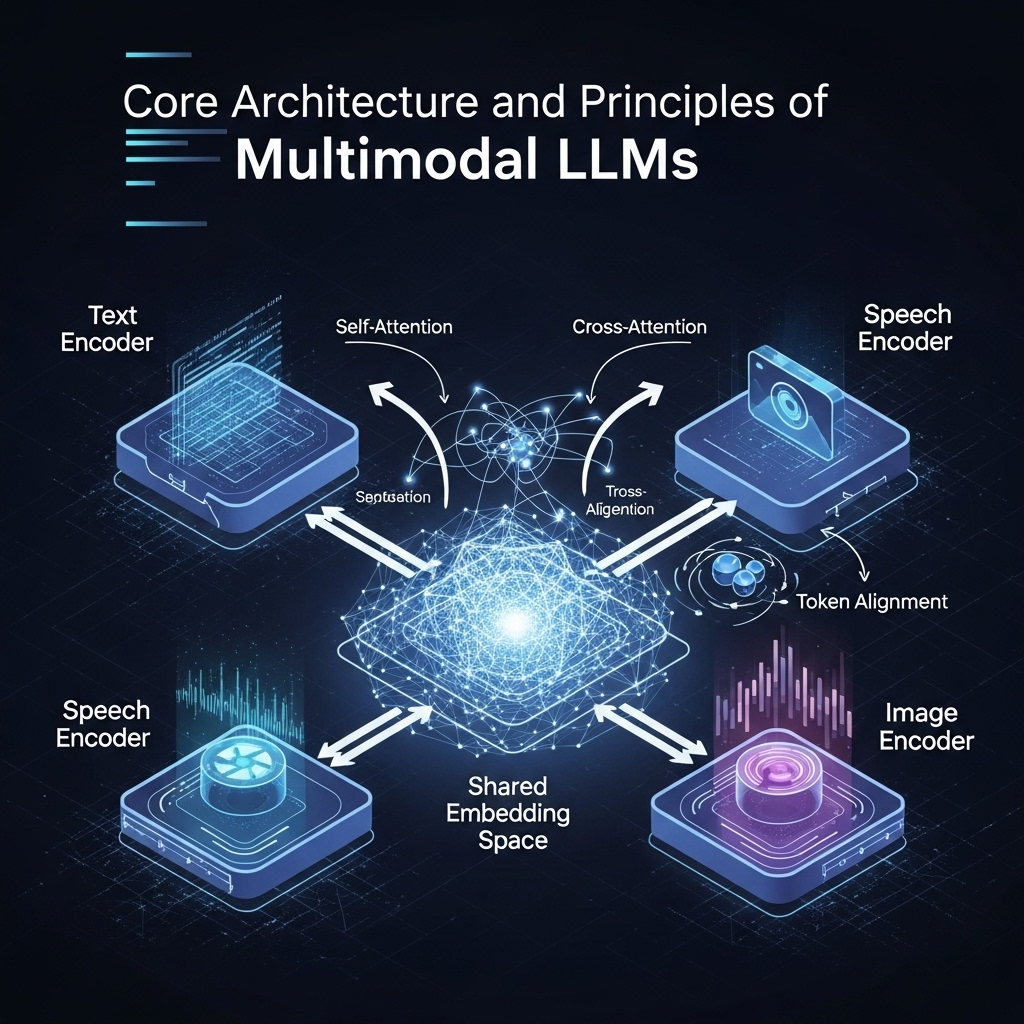

멀티모달 LLM의 핵심 구조와 원리

멀티모달 LLM은 다양한 입력 형식을 처리하기 위해

각각에 특화된 인코더를 사용하며,

텍스트, 음성, 이미지 데이터를 통합하는

공통 임베딩 공간을 구축합니다.

이 통합은 셀프 어텐션, 크로스 어텐션, 토큰 정렬(token alignment)

같은 고급 기술을 통해 이뤄지며,

모델은 서로 다른 형태의 데이터를 참조하여

종합적인 판단을 내릴 수 있습니다.

| 입력 유형 | 전처리 방식 | 모델 예시 |

| 텍스트 | 토크나이제이션 | GPT 시리즈 |

| 이미지 | CNN, ViT | CLIP, Flamingo |

| 음성 | MFCC, Wave2Vec | Whisper, SpeechT5 |

대표 모델 : CLIP에서 GPT-4o까지

OpenAI의 CLIP은 멀티모달 기술 확산의 기폭제 역할을 하며,

텍스트와 이미지를 함께 학습해 ‘이해 가능한 비전’을 구현했습니다.

이후 Flamingo, Kosmos-1, Gemini 등 다양한 모델이

기술 발전을 이어갔습니다.

2024년 이후에는 GPT-4o와 같이

실시간 음성 대화, 이미지 해석, 비디오 분석까지 통합 가능한

모델이 중심에 서고 있습니다.

산업별 적용 사례 : 기술을 넘어선 변화

멀티모달 LLM은 단순한 기술을 넘어

산업 전체를 변화시키는 촉매입니다.

자율주행에서는 센서 데이터와 지도 정보를 통합하고,

의료 분야에서는 CT 이미지와 문진 데이터를 결합하여

진단을 보조합니다.

고객 응대, 로봇 제어, 창작 툴 등에서도

이미 실사용이 이루어지고 있으며,

다양한 산업 분야에서 폭넓은 확장이 이뤄지고 있습니다.

| 산업 분야 | 적용 사례 |

| 자율주행 | 비전 + 지도 + 센서 통합 분석 |

| 의료 진단 | 이미지 + 문진 데이터 결합 진단 AI |

| 고객 상담 | 음성 + 텍스트 + 감정 분석 기반 상담 시스템 |

기술 진화 방향: 에이전트화와 실시간 대응

멀티모달 LLM은 점차 독립적으로 작업을 수행할 수 있는

에이전트로 진화하고 있습니다.

예를 들어, 실시간으로 영상을 해석하고

상황에 맞게 음성으로 반응하는 AI 비서가 그 대표입니다.

또한, 실시간 대화 처리 능력이 향상되면서

인간과 기계 간의 상호작용이

더 직관적이고 자연스러워지고 있습니다.

데이터와 윤리적 문제 : 더 복잡해지는 과제

다양한 입력이 결합될수록 개인정보 보호와 편향 문제는

더 민감해집니다.

이미지나 음성에서의 민감 정보 처리,

다문화 표현의 공정성 보장,

데이터 처리 기준의 정교함이 중요한 과제가 되고 있습니다.

학습 데이터의 품질과 투명성 확보는

윤리적 AI 개발을 위한 필수 요소입니다.

멀티모달 LLM의 미래와 연구 로드맵

앞으로 멀티모달 LLM은 더 많은 감각 데이터를 이해하고,

맥락 간의 연결 능력을 강화하며,

인간 수준의 판단력을 향해 나아갈 것입니다.

다중 프롬프트 처리, 실시간 상호작용, 창의적 합성 능력이

크게 향상될 것이며,

학습 효율성과 연산 자원 최적화 역시 중요한 이슈가 됩니다.

세계 주요 연구기관들은 이와 관련된

오픈소스 생태계를 활발히 확장하고 있습니다.

'재테크' 카테고리의 다른 글

| Stability Diffusion DX 기타 채널 제거 성능 리뷰 (1) | 2025.07.29 |

|---|---|

| K-기반 번역 AI: Papago N2 Beta 직접 체험기 (1) | 2025.07.29 |

| Krisp AI 노이즈 제거 정확도 실사용 보고서 (2) | 2025.07.28 |

| Zapier AI Actions로 SaaS 워크플로 자동화하는 가장 현실적인 방법 (1) | 2025.07.27 |

| HuggingFace Spaces vs Replicate: 어떤 플랫폼이 AI 모델 배포에 더 유리할까? (3) | 2025.07.27 |